Google hat neue Informationen zu seinem Tensor Processing Unit (TPU) v4 veröffentlicht, einem selbst entwickelten Chip, der in den Supercomputern des Unternehmens zum Einsatz kommt.

Google behauptet, dass die Leistung des TPU v4 im Vergleich zur Vorgängerversion v3 um den Faktor 10 verbessert wurde und die Energieeffizienz erhöht wurde. Im Vergleich zu anderen aktuellen ML-Domain-Specific-Accelerators (DSA) soll der TPU v4 zwei- bis dreimal effizienter sein und weniger CO2 emittieren.

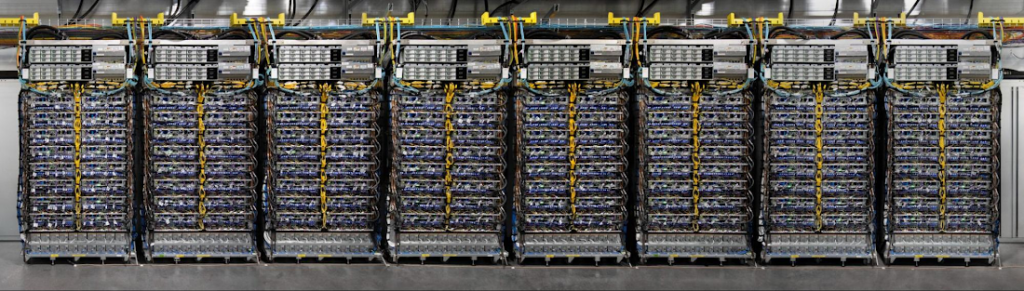

Google verwendet TPUs hauptsächlich für das Training künstlicher Intelligenz und behauptet, dass mehr als 90 Prozent aller Arbeiten in diesem Bereich von TPUs berechnet werden. Das Unternehmen hat in einer wissenschaftlichen Abhandlung beschrieben, wie mehr als 4000 TPUs zu einem Supercomputer verschaltet werden können. Zur Verbindung der einzelnen Chips verwendet Google selbst entwickelte proprietäre optische Schalter. Weitere Informationen finden sich in der Ankündigung des Unternehmens.

Tensor Processing Units (TPUs)

Tensor Processing Units (TPUs) sind speziell für das Training und Inferenz von künstlichen neuronalen Netzen (KNNs) entwickelte Chips von Google. Sie sind Teil der Cloud-Plattform des Unternehmens und sollen die Leistung von KI-Anwendungen beschleunigen. TPUs können für Deep Learning-Modelle verwendet werden, um komplexe Aufgaben wie Bild- und Spracherkennung, Übersetzung, natürliche Sprachverarbeitung und mehr zu bewältigen.

Quelle: Google